Ars-Technica

El jueves, los investigadores de Microsoft anunciaron un nuevo modelo de IA de texto a voz llamado VALLE-E que puede simular de cerca la voz de una persona cuando se le da una muestra de audio de tres segundos. Una vez que aprende una voz específica, VALL-E puede sintetizar el audio de esa persona diciendo cualquier cosa y hacerlo de una manera que intente preservar el tono emocional del hablante.

Sus creadores creen que VALL-E podría usarse para aplicaciones de texto a voz de alta calidad, edición de voz en la que la grabación de una persona podría editarse y modificarse a partir de una transcripción de texto (haciendo que diga algo que no dijo originalmente), y creación de contenido de audio cuando se combina con otros modelos generativos de IA como GPT-3.

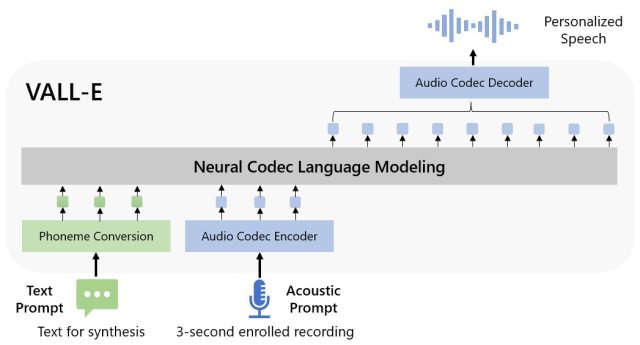

Microsoft llama a VALL-E un «modelo de lenguaje de códec neuronal» y se basa en una tecnología llamada EnCodec, que Meta anunció en octubre de 2022. A diferencia de otros métodos de síntesis de voz que normalmente sintetizan el habla mediante la manipulación de formas de onda, VALL-E genera códigos de códec de audio discretos a partir de indicaciones textuales y acústicas. Esencialmente, analiza el sonido de una persona, divide esa información en componentes discretos (llamados «tokens») a través de EnCodec y utiliza datos de entrenamiento para comparar lo que «sabe» acerca de cómo sonaría esa voz si pronunciara cualquier otra oración además de la muestra de tres segundos. O, como dice Microsoft en el papel VAL-E:

Para sintetizar voz personalizada (por ejemplo, zero-shot TTS), VALL-E genera los tokens acústicos correspondientes condicionados por los tokens acústicos de la grabación inscrita de 3 segundos y el indicador de fonema, que restringen respectivamente al hablante y la información del contenido. Finalmente, los tokens acústicos generados se utilizan para sintetizar la forma de onda final con el decodificador de códec neuronal correspondiente.

Microsoft entrenó las capacidades de texto a voz de VALL-E en una biblioteca de audio, ensamblada por Meta, llamada LibriLuz. Contiene 60.000 horas de habla inglesa de más de 7.000 hablantes, en su mayoría extraídos de LibriVox audiolibros de dominio público. Para que VALL-E genere un buen resultado, la voz en la muestra de tres segundos debe coincidir estrechamente con una voz en los datos de entrenamiento.

En el VAL-E sitio web de muestra, Microsoft proporciona docenas de ejemplos de audio del modelo de IA en acción. De las muestras, el «Speaker Prompt» es el audio de tres segundos proporcionado a VALL-E que debe imitar. La «Verdad básica» es una grabación preexistente de ese mismo orador pronunciando una frase en particular con fines de comparación (al igual que el «control» en el experimento). La «línea de base» es un ejemplo de síntesis proporcionada por un proceso de síntesis de texto a voz convencional, y la muestra «VALL-E» es el resultado del modelo VALL-E.

microsoft

Mientras usaban VALL-E para generar estos resultados, los investigadores ingresaron solo la muestra de «Indicador del hablante» de tres segundos y una cadena de texto (lo que querían que dijera la voz) en VALL-E. Así que compare la muestra «Ground Truth» con la muestra «VALL-E». En algunos casos, las dos muestras son muy cercanas. Algunos resultados de VALL-E parecen generados por computadora, pero otros podrían confundirse con el habla humana, que es el objetivo del modelo.

Además de preservar el timbre vocal y el tono emocional de un hablante, VALL-E también puede imitar el «ambiente acústico» de la muestra de audio. Por ejemplo, si la muestra es de una llamada telefónica, la salida de audio simulará las propiedades acústicas y de frecuencia de una llamada telefónica en su salida sintetizada (esta es una forma elegante de decir que también sonará como una llamada telefónica). Y el de Microsoft muestras (en la sección «Síntesis de diversidad») demuestran que VALL-E puede generar variaciones en el tono de voz modificando la semilla aleatoria utilizada en el proceso de generación.

Tal vez debido a la capacidad de VALL-E de generar travesuras y engaños, Microsoft no proporcionó el código de VALL-E para que otros lo experimentaran, por lo que no pudimos probar las capacidades de VALL-E. Los investigadores parecen conscientes del daño social potencial que podría traer esta tecnología. Para la conclusión del artículo escriben:

“Dado que VALL-E podría sintetizar el habla que mantiene la identidad del hablante, puede conllevar riesgos potenciales de mal uso del modelo, como la suplantación de identidad de la voz o la suplantación de un hablante específico. Para mitigar estos riesgos, es posible construir un modelo de detección para discriminar si un clip de audio ha sido sintetizado por VALL-E. Principios de IA de Microsoft en la práctica durante el desarrollo posterior de los modelos».