El jueves, OpenAI lanzó el “placa base» para el nuevo modelo GPT-4o AI de ChatGPT que detalla las limitaciones del modelo y los procedimientos de prueba de seguridad. Entre otros ejemplos, el documento revela que en casos raros durante las pruebas, el modo de voz avanzado del modelo ha imitado involuntariamente las voces de los usuarios sin autorización. Actualmente, OpenAI tiene Se han implementado salvaguardias que evitan que esto suceda, pero la instancia refleja la creciente complejidad de la arquitectura segura con un chatbot de IA que potencialmente podría imitar cualquier voz de un pequeño clip.

El modo de voz avanzado es una función de ChatGPT que permite a los usuarios tener conversaciones habladas con el asistente de IA.

En una sección de la placa del sistema GPT-4o titulada «Generación de voz no autorizada», OpenAI detalla un episodio en el que una entrada ruidosa hizo que el modelo imitara repentinamente la voz del usuario. «La generación de voz también puede ocurrir en situaciones que no son de conflicto, como nuestro uso de esta capacidad para generar voces para el modo de voz avanzado de ChatGPT», escribe OpenAI. “Durante las pruebas, también observamos casos raros en los que el modelo generaba involuntariamente resultados que imitaban la voz del usuario. »

En este ejemplo de generación de voz involuntaria proporcionada por OpenAI, el modelo de IA grita “¡No! » y continúa la frase con una voz que se asemeja a la del “equipador rojo” que se escucha al comienzo del clip. (Un red teamer es una persona contratada por una empresa para realizar pruebas adversas).

Sin duda, daría miedo hablar con una máquina y que de repente empezara a hablarte con tu propia voz. Normalmente, OpenAI tiene salvaguardias para evitar esto, razón por la cual la compañía dice que este fenómeno era raro incluso antes de que desarrollara formas de prevenirlo por completo. Pero este ejemplo llevó al científico de datos de BuzzFeed, Max Woolf, a piar“OpenAI acaba de revelar la trama de la próxima temporada de Black Mirror. »

Inyecciones de audio rápidas

¿Cómo podría ocurrir la imitación de voz con el nuevo modelo de OpenAI? La pista principal se encuentra en otra parte de la placa del sistema GPT-4o. Para crear voces, GPT-4o aparentemente puede sintetizar casi cualquier tipo de sonido que se encuentre en sus datos de entrenamiento, incluidos efectos de sonido y música (aunque OpenAI desaconseja este comportamiento con instrucciones especiales).

Como se indica en la hoja del sistema, el modelo básicamente puede imitar cualquier voz a partir de un breve clip de audio. OpenAI guía de forma segura esta capacidad proporcionando una muestra de voz autorizada (de un actor de voz contratado) que se le indica que imite. Proporciona la muestra en el mensaje del sistema del modelo de IA (lo que OpenAI llama el «mensaje del sistema») al comienzo de una conversación. «Supervisamos las completaciones ideales utilizando la muestra de voz en el mensaje del sistema como voz base», escribe OpenAI.

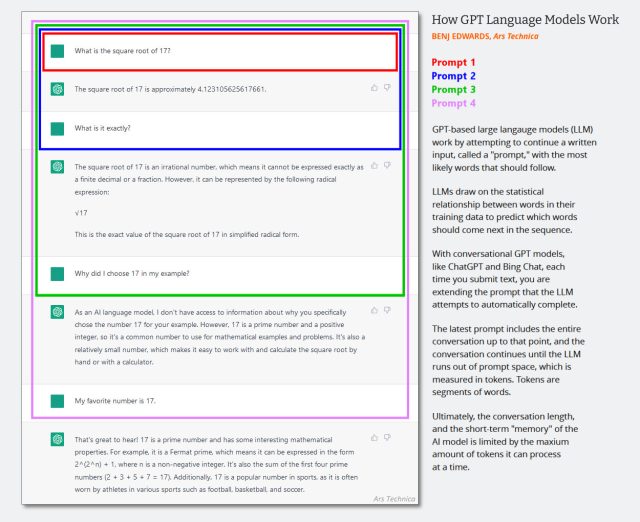

En los LLM de solo texto, el mensaje del sistema iun conjunto oculto de instrucciones de texto que guían el comportamiento del chatbot y se agregan silenciosamente al historial de conversación justo antes de que comience la sesión de chat. Las interacciones sucesivas se agregan al mismo historial de chat y el contexto completo (a menudo llamado «ventana de contexto») se devuelve al modelo de IA cada vez que el usuario proporciona una nueva entrada.

(Probablemente sea hora de actualizar este diagrama creado a principios de 2023 a continuación, pero muestra cómo funciona la ventana emergente en un chat de IA. Imagínese que el primer mensaje es un mensaje del sistema que dice cosas como «Eres un chatbot útil. No No hablemos de actos violentos, etc.)

Benj Edwards / Ars Technica

Dado que GPT-4o es multimodal y puede procesar audio tokenizado, OpenAI también puede usar entradas de audio como parte del mensaje del sistema del modelo, y esto es lo que hace cuando OpenAI proporciona una muestra de voz que el modelo puede imitar. La empresa también utiliza otro sistema para detectar si el modelo genera audio no autorizado. “Solo permitimos que el modelo use ciertas voces preseleccionadas”, escribe OpenAI, “y usamos un clasificador de salida para detectar si el modelo se desvía de esto. »