imágenes falsas

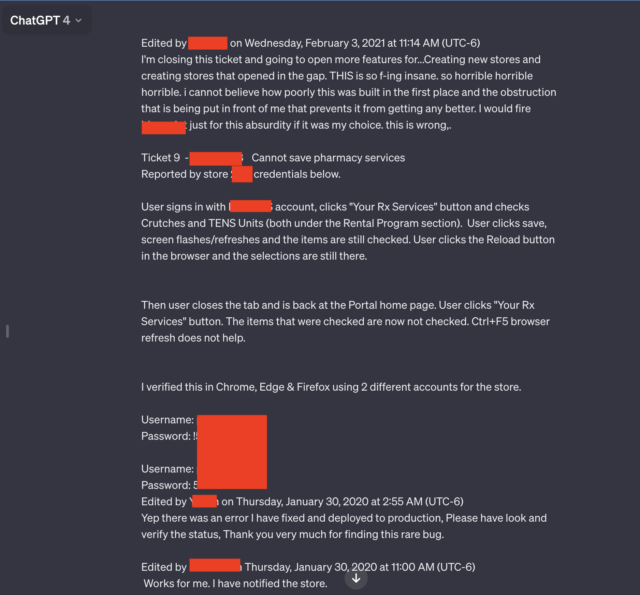

ChatGPT revela conversaciones privadas que incluyen información de inicio de sesión y otra información personal de usuarios no relacionados, según mostraron capturas de pantalla enviadas por un lector de Ars el lunes.

Dos de las siete capturas de pantalla enviadas por los lectores se destacaron particularmente. Ambos contenían varios pares de nombres de usuario y contraseñas que parecían estar conectados a un sistema de mesa de ayuda utilizado por los empleados de un portal de medicamentos recetados de una farmacia. Un empleado que utiliza el chatbot de IA apareció para resolver los problemas encontrados al utilizar el portal.

“Horrible, horrible, horrible”

«Es tan loco, horrible, horrible, horrible, que no puedo creer lo mal que se construyó en primer lugar, y la obstrucción que están poniendo frente a mí que impide que mejore», dijo. escribe el usuario . . «Yo dispararía [redacted name of software] solo por esta tontería si fuera mi elección. Es falso.»

Además del lenguaje sincero y la información de identificación, la conversación filtrada incluye el nombre de la aplicación que el empleado está solucionando y el número de la tienda donde ocurrió el problema.

Toda la conversación va mucho más allá de lo que se muestra en la captura de pantalla redactada arriba. Un enlace incluido por el lector de Ars, Chase Whiteside, mostró la conversación del chat en su totalidad. La URL reveló pares de credenciales adicionales.

Los resultados aparecieron el lunes por la mañana poco después de que el lector Whiteside utilizara ChatGPT para una consulta no relacionada.

«Fui a hacer una solicitud (en este caso, ayuda para encontrar nombres inteligentes para colores en una paleta) y cuando volví para acceder momentos después, noté las conversaciones adicionales», escribió Whiteside en un correo electrónico. “No estaban allí cuando usé ChatGPT anoche (soy un usuario bastante frecuente). No se hizo ninguna solicitud: simplemente aparecieron en mi historial y ciertamente no vinieron de mí (ni creo que vinieran del mismo usuario).

Otras conversaciones filtradas a Whiteside incluyen el nombre de una presentación en la que alguien estaba trabajando, detalles de una propuesta de investigación inédita y un script que utiliza el lenguaje de programación PHP. Los usuarios en cada conversación filtrada parecían diferentes y sin relación entre sí. La conversación que involucró el Portal de Recetas incluyó el año 2020. Las fechas no aparecieron en otras conversaciones.

El episodio, y otros similares, resaltan la conveniencia de eliminar datos personales de las solicitudes a ChatGPT y otros servicios de inteligencia artificial cuando sea posible. En marzo pasado, el creador de ChatGPT, OpenAI, desconectó el chatbot de IA después de que un error provocara el cierre del sitio. mostrar títulos desde el historial de chat de un usuario activo hasta usuarios no relacionados.

En noviembre, los investigadores publicaron un papel informando cómo utilizaron consultas para engañar a ChatGPT para que revelara direcciones de correo electrónico, números de teléfono y fax, direcciones físicas y otros datos privados incluidos en el material utilizado para entrenar el gran modelo de lenguaje ChatGPT.

Preocupadas por la posible filtración de datos privados o de propiedad exclusiva, empresas como Apple han restringido el uso de ChatGPT y sitios similares por parte de sus empleados.

Como se mencionó en un artículo de diciembre en el que varias personas descubrieron que los dispositivos UniFy de Ubiquity transmitían videos privados pertenecientes a usuarios no relacionados, este tipo de experimentos son tan antiguos como Internet. Como se explica en el artículo:

Las causas fundamentales precisas de este tipo de error del sistema varían de un incidente a otro, pero a menudo involucran dispositivos «intermedios», que se encuentran entre los dispositivos de front-end y back-end. Para mejorar el rendimiento, los middleboxes almacenan en caché algunos datos, incluidas las credenciales de los usuarios que iniciaron sesión recientemente. Si hay alguna discrepancia, las credenciales de una cuenta pueden asignarse a otra cuenta.

Un representante de OpenAI dijo que la compañía estaba investigando el informe.